我们正观察到一个明显的趋势:越来越多的企业选择将其大语言模型(LLM)基础架构迁回本地部署。

无论是为了降低延迟、满足合规要求,还是保护数据隐私,在自有硬件上使用开源模型进行自托管,都能让企业牢牢掌控自身的AI发展路径。

然而,将LLM从实验环境扩展到生产级服务,并不是一件容易的事,它往往意味着高昂的成本和复杂的技术挑战。

为此,一个全新的开源框架llm-d应运而生。在红帽、IBM、谷歌等重量级贡献者的推动下,llm-d专注于问题的核心:AI推理——也就是模型根据提示(prompt)、智能体(agent)、检索增强生成(RAG)等输入生成结果的过程。

通过引入智能调度(解耦)和面向AI的路由机制,llm-d能够为LLM提供动态而智能的工作负载分配。

为什么这如此关键?接下来,我们将深入了解llm-d的工作方式,以及它如何在提升性能的同时,大幅降低AI成本。

在Kubernetes等平台上扩展传统Web服务,通常有一套成熟的模式可循。标准HTTP请求往往快速、统一且无状态。而LLM推理的扩展,却是一个截然不同的问题。

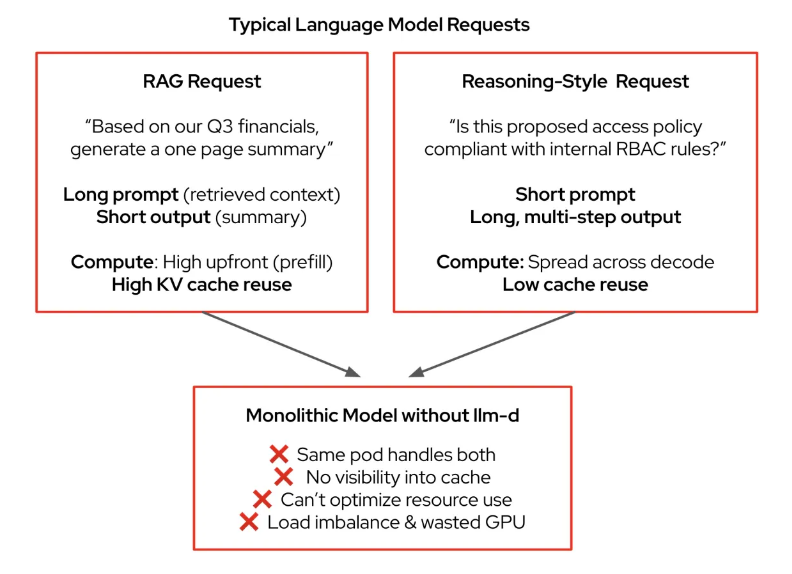

其根源之一在于请求特征的高度差异化。比如,RAG(检索增强生成)模式可能会使用一个包含大量向量数据库上下文的长提示,却只生成一句简短的回答;相反,一个复杂的推理任务可能从简短的提示开始,却输出冗长的、多步骤的结果。这种差异会导致负载不均,从而拖慢整体性能,并增加尾部延迟(ITL)。

此外,LLM推理高度依赖键值(KV)缓存——相当于LLM的短期记忆,用于存储中间结果。但传统负载均衡器对此一无所知,无法感知缓存状态,结果就是请求路由低效,算力资源也被严重浪费。

在Kubernetes环境中,目前的常见做法是将LLM打包成一个单体容器——一个庞大且不透明的“黑盒子”,既缺乏可见性,也缺少可控性。再加上对提示结构、Token数量、响应延迟目标(SLO)、缓存可用性等关键因素的忽视,使得扩展难度更大。

简而言之,当下的推理系统效率低下,动辄消耗远超所需的计算资源。

虽然vLLM已经在多种硬件上提供了广泛的模型支持,但llm-d更进一步。它基于现有企业IT基础架构,带来分布式与高级推理能力,不仅能节省资源,还能显著提升性能:

首个Token生成时间(TTFT)提升3倍

在延迟(SLO)约束下吞吐量翻倍

尽管llm-d拥有一系列强大的创新功能,但其核心聚焦在两大关键突破:

解耦(Disaggregation)

在推理过程中,将提示处理(预填充阶段Prefill)与Token生成(解码阶段Decode)拆分为独立的工作负载(Pod)。由于这两个阶段的计算需求完全不同,这种拆分方式使它们能够独立扩展和优化,从而更高效地利用硬件加速器。

智能调度层(Intelligent Scheduling Layer)

在Kubernetes Gateway API的基础上扩展,支持更细粒度的请求路由。调度器会结合实时数据(如KV缓存利用率、Pod负载情况),将请求分配到最优实例,最大化缓存命中率,并在集群中实现均衡负载。

此外,llm-d还能在请求间缓存KV对,避免重复计算;并将LLM推理拆解为模块化、智能化的服务,实现高性能的可扩展性。同时,它也充分继承和利用了vLLM本身的广泛支持。接下来,我们将深入了解这些技术,以及llm-d在实践中的应用案例。

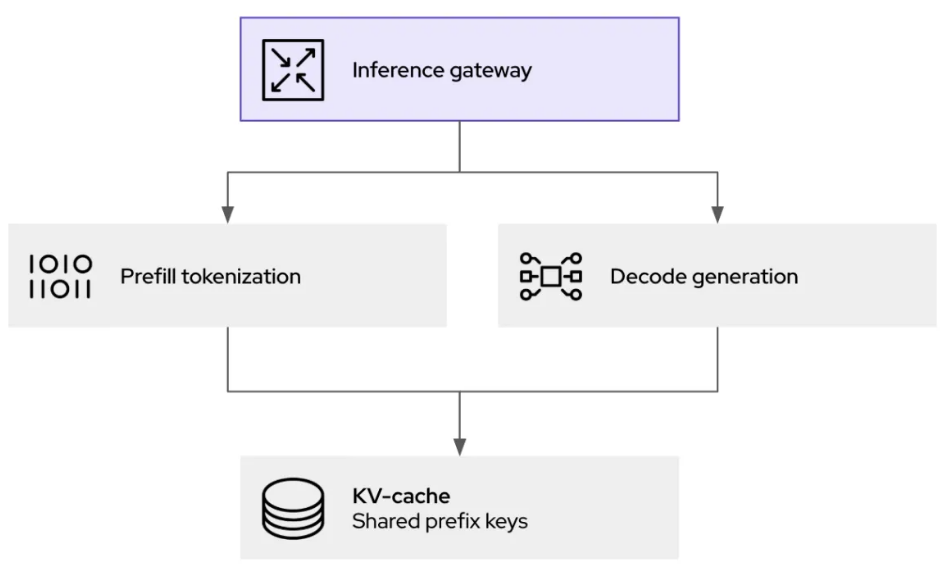

在LLM推理中,预填充(prefill)阶段与解码(decode)阶段存在根本差异,这给统一的资源分配带来了挑战。

预填充阶段:负责处理输入提示,通常计算密集型,需要高算力来生成初始KV缓存条目。

解码阶段:逐个生成Token,往往受限于内存带宽,主要涉及KV缓存的读写,计算需求相对较低。

通过引入解耦,llm-d能够将这两类截然不同的计算任务分别交给独立的Kubernetes Pod处理。这样,预填充Pod可以配备适合计算密集型任务的资源,而解码Pod则采用针对内存带宽优化的配置,从而实现资源的最优利用,提高吞吐量并降低延迟。

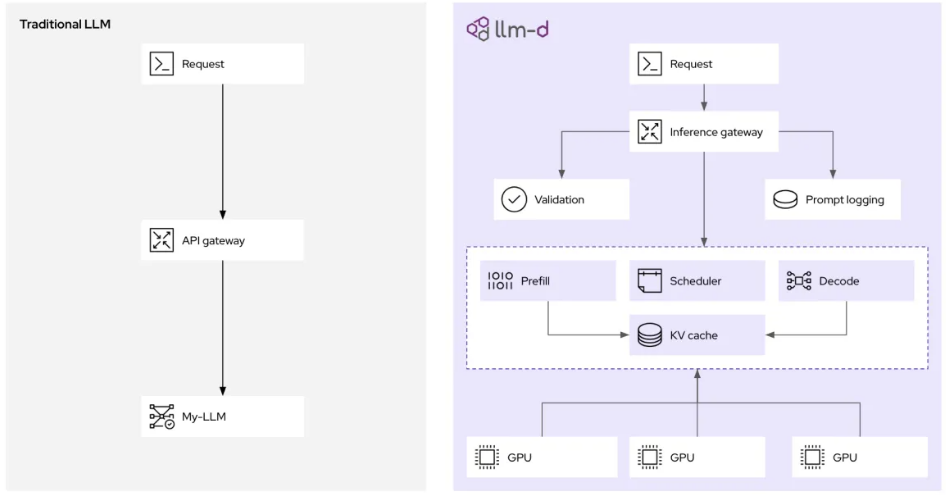

llm-d性能提升的核心在于其智能调度路由器,它负责协调推理请求的处理位置与方式。

当推理请求到达基于kgateway的llm-d网关时,并不会简单地转发到下一个空闲Pod,而是由端点选择器(EPP)——llm-d调度器的核心组件——结合实时数据做出最优决策:

KV缓存感知:调度器会维护所有vLLM副本的KV缓存状态索引。如果一个新请求与某个Pod上已缓存的会话共享前缀,调度器会优先路由到该Pod,从而显著提升缓存命中率,避免重复的预填充计算,直接降低延迟。

负载感知:调度器不仅统计请求数量,还会评估每个vLLM Pod的实际负载,包括GPU内存使用率和处理队列长度,以防止性能瓶颈。

llm-d的推理网关会将请求分别路由到预填充(tokenization)和解码(generation)阶段的Pod,这些Pod共享同一KV缓存。

这种Kubernetes原生的方法,为生成式AI推理提供策略、安全与可观测性层。不仅能够高效处理流量,还支持提示日志记录与审计(满足治理与合规需求),并在请求进入推理前设置安全护栏。

llm-d项目正迎来蓬勃发展。与更适合单机环境的vLLM不同,llm-d面向的是集群运维人员,旨在实现高性能、低成本的AI推理。

AI的未来建立在开放与协作的原则之上。借助vLLM社区和llm-d项目,红帽正努力让AI对全球开发者更加易用、经济且强大。